설치

최근에 핫했던 deepseek를 체험해 보기 위해 ollama를 통해 deekseek를 설치해 봤다. 노트북 램이 64GB인 터라 여유가 있는 편이었지만 응답 속도등을 고려할 때 deepseek-r1:32b 모델이 지금 환경에선 최대치인 것 같아서 7b, 14b, 32b 세 가지 모델을 다운로드 받아봤다. 참고로 노트북 스펙은 i7-10850H, nvidia gtx-1650Ti MaxQ이다.

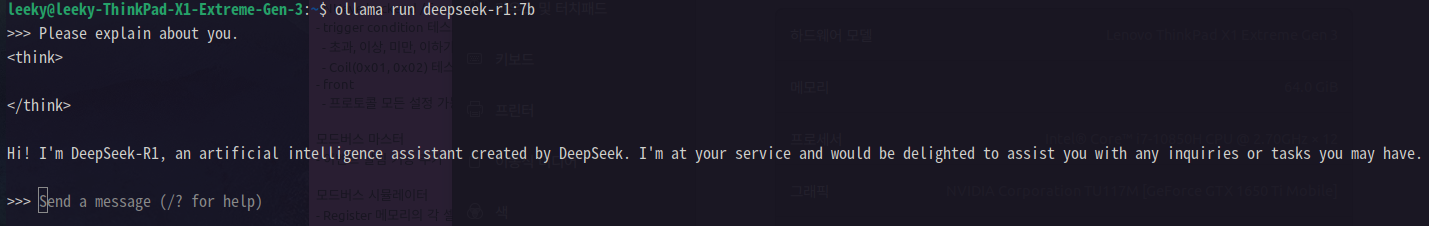

ollama를 통해 간단히 deepseek을 실행해 보면 7b 모델의 경우 신속하게 대답하는 편이다. 단, 한글은 지원되지 않는 것 같다.

문제 발생

터미널 상에서는 사용상의 불편함도 있고 편의 기능도 없고 해서 Open WebUI를 이용해 ollama에 설치된 모델들을 이용하려고 공식 홈페이지에 설명된 대로 명령을 입력해 설치했다. 도커를 이용한 설치 방식을 사용했다.

설치할 때 GPU support 방식으로는 설치하지 못했다. 물론 설치한다고 gtx-1650Ti mobile 버전에서 성능이 잘 나올 것 같지도 않고, 실제로 설치해 보니 드라이버 관련 에러들이 많아 일단 패스했다.

그리고, 웹페이지를 열어 Open WebUI 접속. 기본 접속 주소는 http://localhost:3000

간단한 초기 설정 후 페이지가 떴는데 좌측 상단에 모델 선택 부분에 선택할 수 있는 모델 목록에 아무것도 나오지 않았다.

분명 ollama에는 모델들이 설치돼 있음을 확인했다.

해결

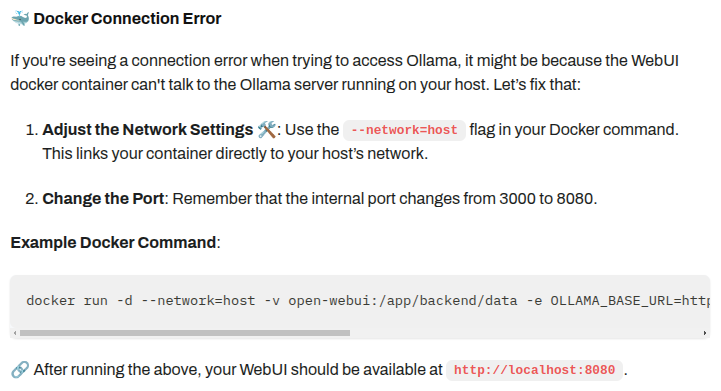

웹페이지상에서 설정 등을 찾아봤지만 모델 목록은 나오지 않았다. 그래서 공식 홈페이지 설명을 찾아봤는데 아래와 같은 설명이 있었다.

아마도 ollama 서버에 접속하지 못해 발생한 문제인 듯 싶다. 위 공식 문서에 안내대로 아래와 같이 입력해 다시 컨테이너를 생성했다.

# 기존 컨테이너 삭제

$ sudo docker stop open-webui

$ sudo docker rm open-webui

# 컨테이너 재생성

$ sudo docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

그리고 Open WebUI 웹페이지 주소는 http://localhost:8080으로 변경.

이제는 정상적으로 모델 목록이 나타난다.